『qpstudy 2013.07 懇親会 〜ドキッ!エンジニアだらけのビアバッシュ!〜』でLTしてきました。

今回はこういう流れで、急いでLT資料作って懇親会だけ参加しました。

今日は極力、外出てよう。ジム行って、喫茶店で本読んで、夜はだれか飲みに行く?

2013-07-28 08:16:17 via web

@mikeda qp行けば?わたくしは懇親会から参加予定なのです。

2013-07-28 08:29:59 via twicca to @mikeda

@netmarkjp 今日、qpstudyだったのか。自分も懇親会から参加するかなぁ

2013-07-28 08:49:55 via web to @netmarkjp

LTは『自分もいつのまにかいい歳になって、将来のこととか考えないとなぁと思い立って、みんなの意見を聞いてみよう』ってお話でした。

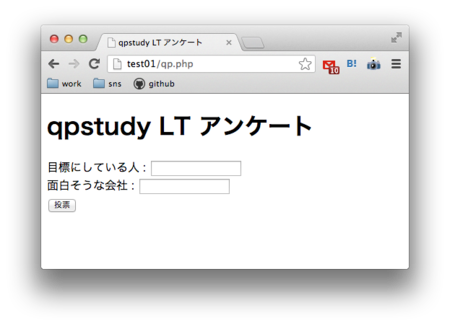

こういう簡単なアンケートページを作って、リアルタイムにみんなの意見を集めました。

アンケートに使ったプログラムはこんな感じです。

表示用のインタフェースはダルいので作らず、ログに出してtail -fしてました。開発系の勉強会だったらフルボッコですね。

<!DOCTYPE html> <html lang="ja"> <head> <meta charset="utf-8"> <meta name="viewport" content="width=device-width,initial-scale=1,user-scalable=no"> <title>qpstudy LT アンケート</title> </head> <body> <h1>qpstudy LT アンケート</h1> <?php $questions = array( // '質問1', // 'テスト', // 'テスト2' // 1 // '転職回数は何回?', // '主な理由は?' // 2 // '今の年俸はいくらくらい?', // '勤続年数、ポジションなど' // 3 // '3次元の嫁/彼女はいる?', // 'どこで見つけた?' // 4 '目標にしている人', '面白そうな会社' ); $answers = $_GET['answers']; if($answers){ echo "あざーす!<br />\n"; echo '<a href="'.$_SERVER['PHP_SELF'].'">戻る</a>'; //オシャレにLTSV形式でログ出力 $result = array(); for($i=0;$i < count($questions);$i++){ $result[] = $questions[$i] .":". $answers[$i]; } file_put_contents("/tmp/qp.log", implode("\t", $result) . "\n", FILE_APPEND); }else{ echo '<form action="'.$_SERVER['PHP_SELF'].'" method="GET">' ."\n"; foreach($questions as $question){ echo "<label>". $question .' : <input type="text" name="answers[]" /></label><br />' ."\n"; } echo '<input type="submit" value="投票" />' ."\n"; echo "</form>\n"; } ?> </body> </html>

ログはこんな感じでした

転職回数は何回?:0 主な理由は?: 転職回数は何回?:0 主な理由は?: 転職回数は何回?:2 主な理由は?:職場環境、収入 転職回数は何回?:0 主な理由は?:なし 転職回数は何回?:1 主な理由は?:社内制度に絶望したっ 転職回数は何回?:3 主な理由は?:やることなくなった 転職回数は何回?:3 主な理由は?:飽きる 転職回数は何回?:2 主な理由は?:病気退職 転職回数は何回?:1 主な理由は?:社長と合わなくて 転職回数は何回?:2 主な理由は?:無し 転職回数は何回?:4 主な理由は?:新しいことがやりたくなった 転職回数は何回?:0回 主な理由は?:0だから、ない! 転職回数は何回?:1 主な理由は?:何となく 転職回数は何回?:0 主な理由は?:やったこと無いです 転職回数は何回?:0回っす。 主な理由は?:踏ん切りなくて、、、 転職回数は何回?:0 主な理由は?:一年目なので 転職回数は何回?:2 主な理由は?:つぶれそうって勘 転職回数は何回?:0回 主な理由は?:そろそろしたい 転職回数は何回?:1 主な理由は?:ドキュメント作成屋になったので 転職回数は何回?:0 主な理由は?:無し 転職回数は何回?:3? 主な理由は?:事業廃止に近い 転職回数は何回?:test 主な理由は?:つぶれそうって勘 転職回数は何回?:2 主な理由は?:疲れた 転職回数は何回?:2 主な理由は?:仕事が面白くない 転職回数は何回?:5 主な理由は?:あきたから 転職回数は何回?:1 主な理由は?:業績 転職回数は何回?:2 主な理由は?:ブラック 転職回数は何回?:0 主な理由は?:やってみたい 転職回数は何回?:1 主な理由は?:引越し 転職回数は何回?:0回 主な理由は?:社内転職は1回しました! 転職回数は何回?:0回っす。 主な理由は?:踏ん切りなくて、、、 転職回数は何回?:1 主な理由は?:将来性 転職回数は何回?:7 主な理由は?:マネー 3次元の嫁/彼女はいる?:めけだ どこで見つけた?:qp 3次元の嫁/彼女はいる?:いないです どこで見つけた?:教えてほしいです 3次元の嫁/彼女はいる?:いる どこで見つけた?: 3次元の嫁/彼女はいる?:いない どこで見つけた?:どこに落ちてるんですか? 3次元の嫁/彼女はいる?:いますー。 どこで見つけた?:ファミレス 3次元の嫁/彼女はいる?:いる どこで見つけた?:共通の趣味 3次元の嫁/彼女はいる?:いない どこで見つけた?:いない 3次元の嫁/彼女はいる?:いる どこで見つけた?: 3次元の嫁/彼女はいる?:いまーす! どこで見つけた?:GOこん! 3次元の嫁/彼女はいる?:いない どこで見つけた?:いないと言っている! 3次元の嫁/彼女はいる?:年齢が危ないが一応 どこで見つけた?:Twitter経由 3次元の嫁/彼女はいる?:いない どこで見つけた?:紹介はしました 3次元の嫁/彼女はいる?:いる どこで見つけた?: 3次元の嫁/彼女はいる?:いない どこで見つけた?: 3次元の嫁/彼女はいる?:いますん どこで見つけた?:1しゃめの研修 3次元の嫁/彼女はいる?:いなくなった どこで見つけた?:教えて 3次元の嫁/彼女はいる?:いる どこで見つけた?:勉強会 3次元の嫁/彼女はいる?:いない どこで見つけた?:見つけられない 3次元の嫁/彼女はいる?:いない!!!!!!!! どこで見つけた?: 3次元の嫁/彼女はいる?:いない どこで見つけた?: 3次元の嫁/彼女はいる?:前に居た どこで見つけた?:会社 3次元の嫁/彼女はいる?:元嫁はいた どこで見つけた?:勉強会 3次元の嫁/彼女はいる?:いる どこで見つけた?:大学時代 3次元の嫁/彼女はいる?:いる どこで見つけた?:忘れた 3次元の嫁/彼女はいる?:いない どこで見つけた?:紹介はしました 3次元の嫁/彼女はいる?:いる どこで見つけた?:勉強会 3次元の嫁/彼女はいる?:いない どこで見つけた?:前カノはスポーツジム 3次元の嫁/彼女はいる?:いますー。 どこで見つけた?:ファミレス 目標にしている人:銀河 面白そうな会社:銀河さん 目標にしている人:特に思いつきません 面白そうな会社:さくら 目標にしている人:不明 面白そうな会社:不明 目標にしている人:いないです 面白そうな会社:ガールフレンド(仮)のとこ 目標にしている人:せちろーさん 面白そうな会社:銀河さん 目標にしている人:かぜぶろさん 面白そうな会社:NHN 目標にしている人:もりすさん 面白そうな会社:えぬえいちえぬ 目標にしている人:リーダー 面白そうな会社:シャッツキステ 目標にしている人:スタジオなんか屁 面白そうな会社:マーベラス 目標にしている人:たごもりさん 面白そうな会社:line 目標にしている人:h.shinonome 面白そうな会社: 目標にしている人:ひろせさん 面白そうな会社:DeNA, CyberAgent, AmazonDataServices 目標にしている人: 面白そうな会社:特許事務所 目標にしている人:いる 面白そうな会社: 目標にしている人:います 面白そうな会社:AWS 目標にしている人:みけだ 面白そうな会社: 目標にしている人:MSの西脇さん 面白そうな会社:うーん 目標にしている人:みけだ 面白そうな会社: 目標にしている人:めけだ 面白そうな会社: 目標にしている人:めけだ 面白そうな会社:てけだ 目標にしている人:みけださん 面白そうな会社: 目標にしている人: 面白そうな会社:お金くれるところ 目標にしている人:#ヤマン 面白そうな会社:AWS

いろいろ参考になりました。みなさんご意見ありがとうございました!